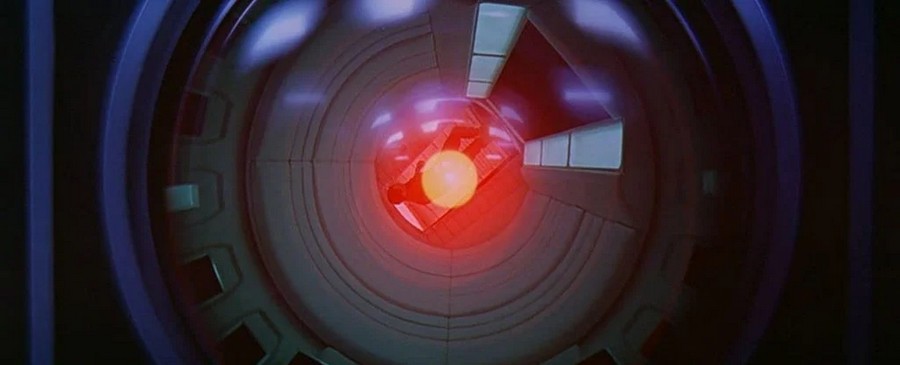

Մարդկությանը տապալող արհեստական ինտելեկտի գաղափարը քննարկվել է տասնամյակներ շարունակ, և 2021 թվականի հունվարին գիտնականները տվել են իրենց վճիռը, թե արդյոք մենք կարող ենք կառավարել բարձր մակարդակի համակարգչային գերհետախուզությունը: Պատասխանե՞լ Գրեթե հաստատ ոչ:

Խնդիրն այն է, որ գերմիտքի կառավարումը մարդկային հասկացողությունից շատ հեռու կպահանջի այդ գերմիտքի մոդելավորում, որը մենք կարող ենք վերլուծել: Բայց եթե մենք ի վիճակի չենք դա հասկանալ, ապա անհնար է նման սիմուլյացիա ստեղծել։

«Մարդկանց մի վնասիր»-ի նման կանոններ չեն կարող սահմանվել, քանի դեռ մենք չենք հասկանում, թե արհեստական ինտելեկտի (AI) ինչ սցենարներ կառաջարկի, կարծում են 2021 թվականի հոդվածի հեղինակները։ Հենց որ համակարգչային համակարգը աշխատի այնպիսի մակարդակով, որը գերազանցում է մեր ծրագրավորողների հնարավորությունները, մենք այլևս չենք կարողանա սահմաններ դնել։

«Գերհետախուզությունը սկզբունքորեն տարբեր խնդիր է, քան նրանք, որոնք սովորաբար ուսումնասիրվում են «ռոբոտների էթիկայի» դրոշի ներքո», - գրում են հետազոտողները: «Դա պայմանավորված է նրանով, որ գերմիտքը բազմակողմանի է և, հետևաբար, պոտենցիալ ի վիճակի է մոբիլիզացնել տարբեր ռեսուրսներ՝ մարդկանց համար պոտենցիալ անհասկանալի, առավել ևս կառավարելի նպատակներին հասնելու համար»:

Թիմի հիմնավորումների մի մասը գալիս է դադարեցման խնդիրներ, առաջարկել է Ալան Թյուրինգը 1936 թ. Խնդիրն այն է, որ պարզել, թե արդյոք համակարգչային ծրագիրը կգա եզրակացության և կպատասխանի (և կդադարեցնի), թե պարզապես ընդմիշտ կշրջվի՝ փորձելով գտնել պատասխանը:

Ինչպես Թյուրինգն ապացուցեց օգնությամբ խելացի մաթեմատիկա, թեև մենք դա կարող ենք իմանալ որոշ հատուկ ծրագրերի համար, տրամաբանորեն անհնար է գտնել մի միջոց, որը թույլ կտա մեզ իմանալ դա յուրաքանչյուր պոտենցիալ ծրագրի համար, որը երբևէ կարող է գրվել: Սա մեզ վերադարձնում է արհեստական ինտելեկտին, որը գերխելացի վիճակում կարող էր միաժամանակ պահել իր հիշողության մեջ բոլոր հնարավոր համակարգչային ծրագրերը:

Հետաքրքիր է նաև.

- OpenAI-ն արհեստական ինտելեկտին սովորեցրել է հրամանները վերածել ծրագրի կոդի

- Արհեստական ինտելեկտը կփնտրի գրավիտացիոն ալիքներ

Ցանկացած ծրագիր, որը գրված է, օրինակ, արգելելու արհեստական ինտելեկտը վնասել մարդկանց և ոչնչացնել աշխարհը, կարող է կամ չի կարող հանգել եզրակացության (և կանգ առնել), մաթեմատիկորեն անհնար է լինել բացարձակապես որոշակի, ինչը նշանակում է, որ այն չի կարող զսպվել: «Դա հիմնականում անօգտագործելի է դարձնում զսպման ալգորիթմը», - հունվարին ասաց համակարգչային գիտնական Իյադ Ռահվանը Գերմանիայի Մաքս Պլանկի Մարդկային զարգացման ինստիտուտից:

AI-ի էթիկայի ուսուցման և աշխարհը ոչնչացնելու արգելքների ուսուցման այլընտրանքը, ինչում ոչ մի ալգորիթմ չի կարող լիովին վստահ լինել, ասում են հետազոտողները, գերմիտքի հնարավորությունները սահմանափակելն է: Օրինակ, այն կարող է կտրված լինել ինտերնետի մի մասից կամ որոշակի ցանցերից:

Վերջերս կատարած հետազոտության հեղինակները մերժում են նաև այս գաղափարը՝ կարծելով, որ այն կսահմանափակի արհեստական ինտելեկտի շրջանակը. ասում են՝ եթե մենք չենք պատրաստվում օգտագործել այն մարդկային հնարավորություններից դուրս խնդիրներ լուծելու համար, ապա ինչո՞ւ ընդհանրապես ստեղծել այն։

Եթե մենք պատրաստվում ենք զարգացնել արհեստական ինտելեկտը, մենք կարող ենք նույնիսկ չիմանալ, թե երբ կհայտնվի գերհետախուզություն՝ մեր վերահսկողությունից դուրս, այնքան անհասկանալի է: Սա նշանակում է, որ մենք պետք է սկսենք լուրջ հարցեր տալ, թե ուր ենք մենք գնում:

«Գերխելացի մեքենան, որը կառավարում է աշխարհը, հնչում է որպես գիտական ֆանտաստիկա», - ասում է համակարգչային գիտնական Մանուել Քեբրյանը Մաքս Պլանկի Մարդկային զարգացման ինստիտուտից: Բայց արդեն կան մեքենաներ, որոնք ինքնուրույն կատարում են որոշ կարևոր առաջադրանքներ, մինչդեռ ծրագրավորողները լիովին չեն հասկանում, թե ինչպես են դա սովորել:

Ուստի հարց է առաջանում՝ արդյոք այն կարող է ինչ-որ պահի դառնալ անկառավարելի ու վտանգավոր մարդկության համար...

Կարդացեք նաև.

- Արհեստական ինտելեկտին հաջողվել է վերարտադրել Պիկասոյի նկարված նկարը

- Արհեստական ինտելեկտը կօգնի կանխատեսել ճանապարհատրանսպորտային պատահարները՝ նախքան դրանք տեղի ունենալը